ct = atct−1 + ztから始める自作LLM SioConvの紹介:時系列モデルを自作で実装してみよう!

詳細情報

| 日時 | 2024年07月24日 22:00 - 22:30 |

|---|---|

| テーマ | ct = atct−1 + ztから始める自作LLM 時系列モデルSioConvの紹介 |

| 発表者 | myxyさん |

| 集会名 | ML集会 |

| 発表資料 | ファイル |

※以下文章はスライド資料を元に自動生成されたものです。

発表のハイライト

- LSTMの簡略化と並列化による高速化を実現

- 自作LLM「SioConv」を開発し、事前学習とファインチューニングを実施

- Wikipediaデータセットを用いた事前学習と、会話応答データセットを用いたファインチューニングで、日本語LLMとしての性能を確認

LSTM:時系列処理の定番モデル

時系列データ処理において、LSTM(Long Short-Term Memory)はTransformerが登場する以前から広く利用されてきました。

LSTMは、過去の情報(隠れ状態)を保持し、現在の入力と合わせて次の出力を予測する仕組みを持っています。

しかし、LSTMには課題も存在します。

例えば、時系列データが長くなると、隠れ状態の伝播経路に全結合層が多数存在するため、計算コストが大きくなってしまい、並列処理が難しくなります。

LSTMの課題:計算コストと並列化の壁

1000ステップの時系列データを予測する場合、LSTMは全結合層を1000回計算する必要があります。

これは、Transformerのように時系列データを並列に処理する手法と比較して、計算時間がかかってしまうという問題点があります。

そこでmyxyさんは、LSTMを簡略化し、並列化できないかと考えました。

SioConv:LSTMを簡略化し並列処理を実現

myxyさんが開発した「SioConv」は、LSTMの構造を簡略化し、並列処理を可能にした自作のLLMです。

忘却ゲートの並列計算:計算を高速化

SioConvでは、LSTMの隠れ状態の伝播経路にある全結合層を削除し、隠れ状態の伝播をスカラー毎の一次式で表現することで簡略化を行いました。

さらに、忘却ゲートをチャンネル毎のスカラーにすることで、並列計算を可能にしました。

マルチヘッド化:メモリ使用量を抑えつつ性能向上

チャンネル毎に忘却ゲートを割り当てる方法だと、系列長×系列長の行列が必要となり、メモリ使用量が膨大になってしまいます。

そこで、チャンネルをいくつかのヘッドに分割し、各ヘッドに忘却ゲートを割り当てることで、メモリ使用量を抑えつつ、性能を向上させています。

Gated Linear Unit(GLU)とGroupNormの活用

SioConvでは、活性化関数にGLU(Gated Linear Unit)を採用し、層の正規化にはGroupNormを使用しています。

これらの手法により、モデルの表現能力を高め、学習の安定化を図っています。

SioConvの実験:事前学習とファインチューニング

myxyさんは、SioConvの性能を評価するために、事前学習とファインチューニングの実験を行いました。

事前学習:WikipediaとMiniPileデータセットで学習

事前学習には、日本語WikipediaとMiniPileを混合したデータセットを使用。

Transformerと類似したアーキテクチャを採用し、約1.6Bのパラメータを持つモデルで学習を行いました。

ファインチューニング:会話応答データセットで調整

事前学習したモデルを、さらに会話応答データセットを用いてファインチューニングすることで、会話応答に特化したモデルへと進化させました。

SioConvの生成例:日本語テキストとチャット応答

SioConvは、事前学習とファインチューニングを通して、日本語テキストの生成やチャット応答において一定の性能を示しました。

例えば、"宮城県("というプロンプトを入力すると、Wikipedia風の文章を生成することができます。

また、チャット形式での質問に対して、それらしい回答を生成することも可能です。

今後の課題:さらなる性能向上を目指して

SioConvは、まだ開発途上のLLMです。

myxyさんは、今後、定量的な評価指標を用いた性能評価や、モデルとデータセットの規模を拡大することで、さらなる性能向上を目指したいと考えています。

また、Hugging Faceなどのプラットフォームでモデルを公開し、多くの人が利用できるようにしたいと考えています。

まとめ

myxyさんの発表では、LSTMの簡略化と並列化、自作LLM「SioConv」の開発、そして事前学習とファインチューニングの実験結果を紹介されました。

SioConvは、日本語テキストの生成やチャット応答に一定の成果を示しており、今後の発展が期待されます。

ML集会の他の発表もチェック!

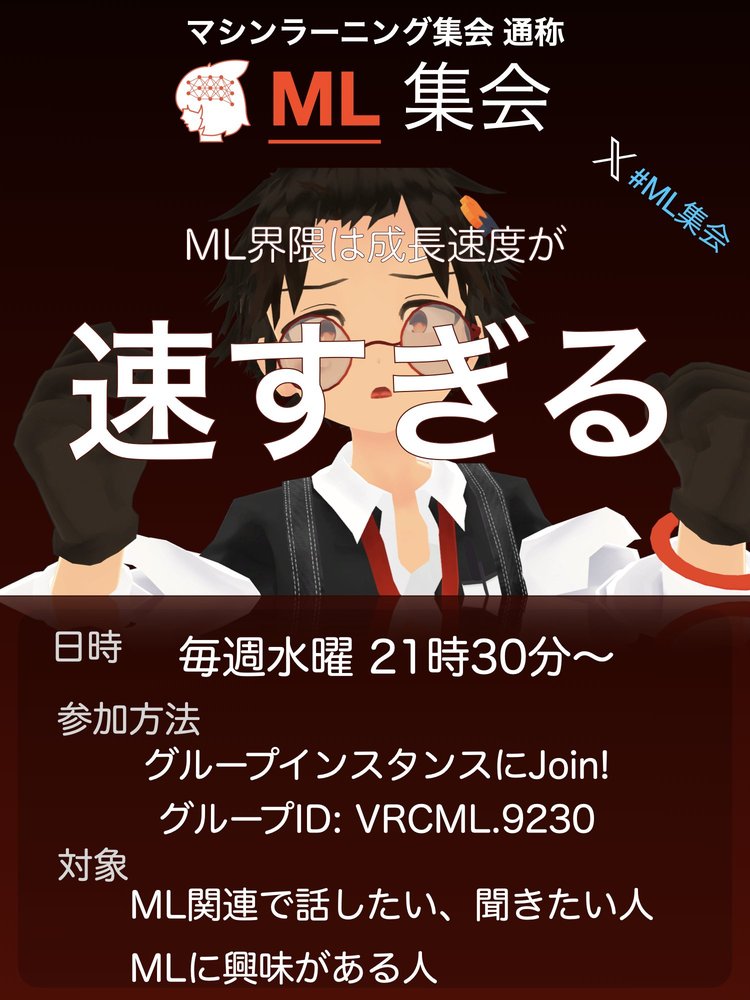

ML集会の開催情報・参加方法

ML集会

開催日: 2024年07月24日

開催時間: 21:30 - 22:30

開催曜日: 水曜日開催周期: 毎週

機械学習(AI)関連でお話しつつ、LTなどをする情報共有会です! 最近のML界隈は成長が速すぎるからみんなで追おう!という思いから生まれました。 現在は自律動作するAIアバターがいたりして... あなたの目の前にいる存在は人ではないかもしれません。 Discordもあるのでそちらもぜひ。