VRChat自律機械知能プロジェクト:P-AMI<Q>の実験結果から見えてきたもの

詳細情報

| 日時 | 2024年11月20日 22:00 - 22:30 |

|---|---|

| テーマ | P-AMI<Q>の実験結果について |

| 発表者 | Earl Klutz(クルツ) |

| 集会名 | ML集会 |

| 発表資料 | ファイル |

※以下文章はスライド資料を元に自動生成されたものです。

発表ハイライト

- VRChat内で自律的に行動するAI「P-AMI<Q>」の進化と、その学習・検証結果について発表されました。

- P-AMI<Q>は、好奇心に基づく内発的動機付けを報酬として学習するAIです。

- I-JEPAとSioConvという2つのモデルを用いて、VRChat内の環境を学習させ、AIの行動を予測・生成する実験が行われました。

- 実験結果から、ラージモデルの方が損失が少なく、ノイズのある環境でも報酬を獲得しやすいことがわかりました。

VRChat自律機械知能プロジェクトとは?

VRChat自律機械知能プロジェクトは、VRChat上に自律機械知能を生み出し、その振る舞いを通して人間や知能そのものの理解を深めることを目的としたプロジェクトです。

クルツさんをはじめ、げそんさん、Myxyさん、Zassouさん、ぶんちんさん、田中スイセンさんなど、多くのメンバーが協力して研究開発を進めています。

プロジェクトでは、AIの振る舞いを記録・解析し、さらに論文にまとめて学会で発表するなど、学術的な側面も重視されています。

VRChatというバーチャル空間を舞台に、AIの知能に関する新しい知見が得られることが期待されています。

P-AMI<Q>:好奇心で動くAI

2023年に実装されたP-AMI<Q>は、原始的な自律機械知能です。

その名の通り、好奇心をベースに、内発的な動機付けを報酬として学習します。

具体的には、予測誤差を報酬として活用することで、AI自身が新しい情報や経験を求めるように設計されています。

予測と現実のずれが大きいほど報酬が高くなり、AIは予測誤差を減らすために積極的に行動し、未知の領域を探求していくのです。

P-AMI<Q>の学習と検証:I-JEPAとSioConv

P-AMI<Q>の学習と検証には、2つの重要なモデルが使われています。

- I-JEPA(Information-maximizing Joint Embedding Predictive Architecture):VRChat環境の画像から特徴量を抽出するモデルです。

- SioConv(State-conditioned Image Convolution):P-AMI<Q>の行動によって変化するVRChat環境を予測するモデルです。

これらのモデルは、VRChat環境でP-AMI<Q>がランダムに動き回っている間に収集した24時間分のデータを使って学習されました。

I-JEPAの検証:画像の復元で確認

I-JEPAの検証では、エンコードされた画像を復元するデコーダーを実装し、復元画像を目視で確認することで、特徴量の抽出能力が確認されました。

ラージモデルとスモールモデルの両方で、驚くほど綺麗に復元できており、I-JEPAがVRChat環境の特徴を捉えていることがわかります。

SioConvの検証:予測画像と実観測の比較

SioConvの検証では、生成された予測画像と実際に観測された画像を比較することで、環境予測の精度が確認されました。

ラージモデルでは、予測画像が実観測画像と非常によく似ており、SioConvがVRChat環境の変化を高い精度で予測できていることがわかります。

Policy(P-AMI<Q>)の検証:シンプルなワールドで確認

Policy(PAMI<Q>)の検証では、昨年と同じシンプルなワールドと、そこにノイズを加えたワールドで、P-AMI<Q>の行動が確認されました。

実験の結果、ノイズ付きワールドの方が未到達エリアは増えるものの、報酬を得やすいことがわかりました。

特にラージモデルでは、ノイズのある環境でも報酬が大きく増加する傾向が見られました。

まとめ

クルツさんの発表では、VRChat自律機械知能プロジェクトにおけるP-AMI<Q>の実験結果が示されました。

好奇心に基づいた学習方法や、I-JEPAとSioConvといったモデルを用いた検証を通して、VRChat環境におけるAIの知能の進化が確認されました。

特に、ラージモデルは、ノイズのある環境でも高い報酬を獲得できるなど、優れた性能を示しました。

今回の発表は、VRChatというバーチャル空間でAIがどのように学習し、行動するかを理解する上で、重要な一歩となるでしょう。

ML集会の他の発表もチェック!

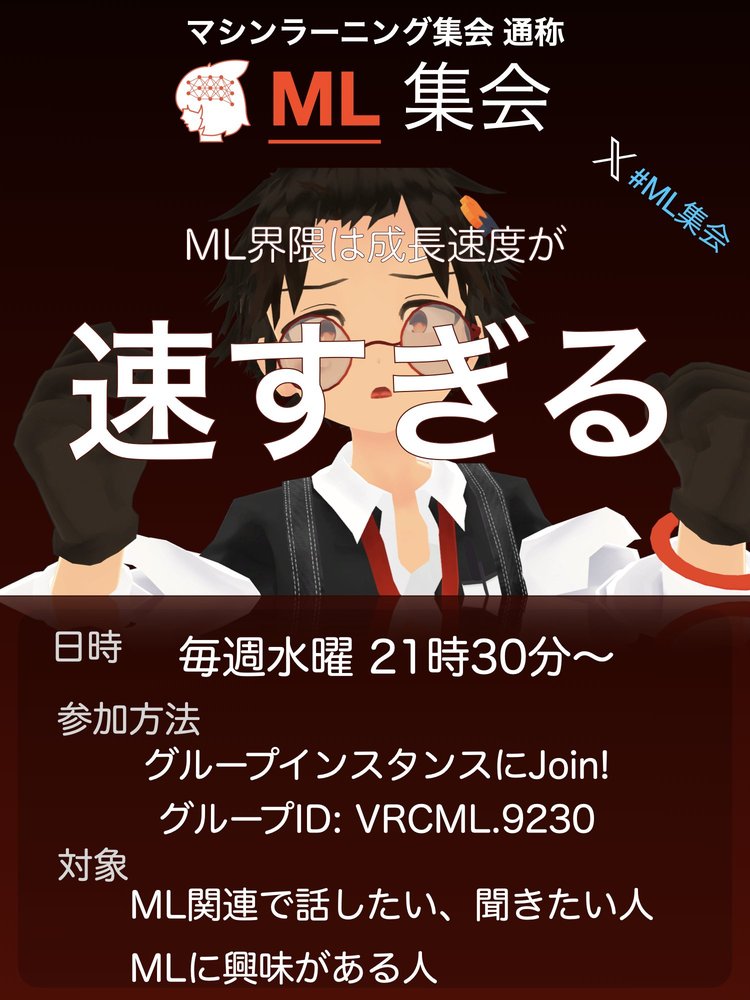

ML集会の開催情報・参加方法

ML集会

開催日: 2024年11月20日

開催時間: 21:30 - 22:30

開催曜日: 水曜日開催周期: 毎週

機械学習(AI)関連でお話しつつ、LTなどをする情報共有会です! 最近のML界隈は成長が速すぎるからみんなで追おう!という思いから生まれました。 現在は自律動作するAIアバターがいたりして... あなたの目の前にいる存在は人ではないかもしれません。 Discordもあるのでそちらもぜひ。