VRChatのVConf24で活躍!Dreamer方式によるPolicy更新手法を解説

詳細情報

| 日時 | 2024年07月17日 22:00 - 22:30 |

|---|---|

| テーマ | Dreamer⽅式のPolicy更新⼿法 |

| 発表者 | GesonAnkoさん |

| 集会名 | ML集会 |

| 発表資料 | ファイル |

※以下文章はスライド資料を元に自動生成されたものです。

発表のハイライト

- VRChatのVConf24で用いられている行動生成器(Policy)の更新手法として、Dreamer方式が採用されました。

- Dreamer方式は、世界モデルと呼ばれる深層学習モデルを用いることで、現実環境に縛られず、計算機上で大量の学習データを作り出し、効率的にPolicyの学習を行うことができます。

- 強化学習の概念や、Dreamer方式のポイント、実動作について理解することで、VRChat上のキャラクターの行動をよりスムーズかつ複雑に制御できる可能性が広がります。

強化学習とは?AIが学習する魔法のテクニック

強化学習は、AIが環境の中で試行錯誤を繰り返しながら、目標達成のための最善の行動を学習していく手法です。

まるでゲームでレベルアップしていくように、AIは経験を通して賢くなっていきます。

強化学習の基本設定:エージェント、環境、そして報酬

強化学習では、エージェントと呼ばれる学習主体が、環境の中で行動し、その結果として得られる報酬によって学習を進めていきます。

例えば、ゲームで言えば、エージェントはプレイヤー、環境はゲームの世界、報酬は獲得したポイントやアイテムになります。

収益の推定:未来の報酬を予測する

強化学習の目標は、報酬の総和である収益を最大化することです。

しかし、収益は未来の報酬も含むため、直接計算することが難しい場合があります。

そこで、状態価値関数と呼ばれる関数を使って、現在の状態から未来の収益を予測します。

λ-Return:未来の報酬を賢く予測する

収益を推定する際に、未来の報酬をどの程度重視するかを決めるのが、割引率です。

λ-Returnは、この割引率と過去の報酬を組み合わせて、より正確な収益の予測を行う手法です。

Dreamer方式:世界モデルで学習を加速

Dreamer方式の採用理由:VConf24における課題解決

VRChatのVConf24で用いられる自律機械知能のPolicyの学習を効率的に行うため、従来のPPO(Proximal Policy Optimization)に代わる手法として、Dreamer方式が採用されました。

PPOは学習データを得るために現実環境と直接やり取りする必要があり、学習に時間がかかってしまうという課題がありました。

登場モデル:Forward Dynamicsで未来を予測

Dreamer方式では、Forward Dynamicsと呼ばれる深層学習モデルが重要な役割を果たします。

Forward Dynamicsは、過去の経験データから、エージェントの行動が環境にどのように影響するかを学習します。

これにより、現実世界と同様の環境を仮想的に作り出すことができ、学習データの生成を高速化できます。

Dreamerの学習:空想の世界で学ぶ

Dreamerは、Forward Dynamicsを使って、仮想的な環境(空想上の軌道)を生成し、その中で学習を進めていきます。

まるで夢の中で練習するようなイメージですね!

ポイント:微分可能なForward Dynamicsと確率的な予測

Dreamer方式の大きな特徴は、Forward Dynamicsが微分可能である点です。

これにより、収益の予測値から直接Policyを更新することができます。

また、Forward Dynamicsは確率的に未来を予測するモデルであり、学習の安定化に貢献しています。

Dreamer方式の実動作:仮想空間での行動生成

Dreamerは、仮想空間(潜在空間)の中で行動を生成し、その軌跡を可視化することができます。

実世界での行動と非常に近い軌跡を生成できることが確認されており、VConf24におけるキャラクターの行動制御に大きな期待が寄せられています。

まとめ

Dreamer方式は、世界モデルを用いて強化学習の学習効率を大幅に向上させる手法です。

VRChatのVConf24で用いられる行動生成器の学習に採用され、よりスムーズで複雑なキャラクターの行動を実現する可能性を秘めています。

強化学習の概念、λ-Return、Forward Dynamics、そしてDreamer方式のポイントを理解することで、VRChatの世界をさらに豊かにできるかもしれません。

ML集会の他の発表もチェック!

ML集会の開催情報・参加方法

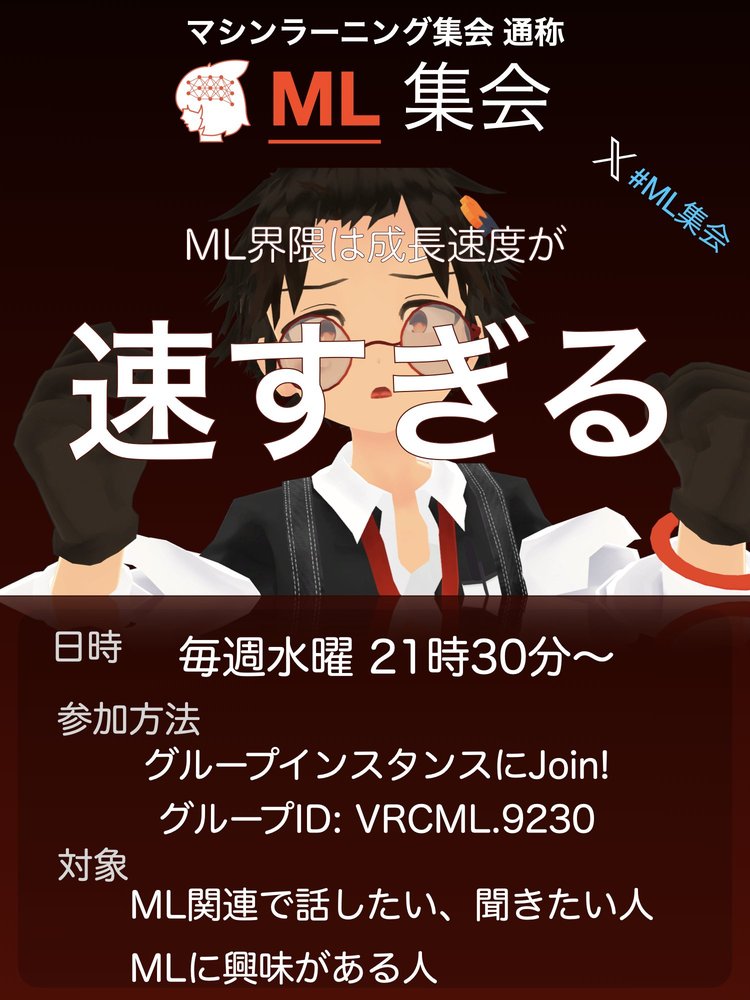

ML集会

開催日: 2024年07月17日

開催時間: 21:30 - 22:30

開催曜日: 水曜日開催周期: 毎週

機械学習(AI)関連でお話しつつ、LTなどをする情報共有会です! 最近のML界隈は成長が速すぎるからみんなで追おう!という思いから生まれました。 現在は自律動作するAIアバターがいたりして... あなたの目の前にいる存在は人ではないかもしれません。 Discordもあるのでそちらもぜひ。