VRChat ML集会 第6回:y=ax+bから始める初心者向けML講座 - 深層学習の基礎と課題、そして革新的なモデルたち!

詳細情報

| 日時 | 2023年06月07日 22:30 - 23:00 |

|---|---|

| テーマ | 第6回y=ax+bから始める初心者向けML講座 |

| 発表者 | Earl Klutz(クルツ) |

| 集会名 | ML集会 |

| 発表資料 | ファイル |

※以下文章はスライド資料を元に自動生成されたものです。

発表のハイライト

- CNN(畳み込みニューラルネットワーク)やDNN(深層ニューラルネットワーク)の基礎を振り返りつつ、深層化すると何が起きるのかを解説

- 深層学習における課題である「勾配消失問題」について、その原因と解決策をわかりやすく説明

- 深層学習モデルの進化の歴史と、ResNetやInceptionモジュールといった革新的なアーキテクチャを紹介

VRChatのML集会で、Earl Klutzさんが「第6回y=ax+bから始める初心者向けML講座」というテーマで発表を行いました。

今回の記事では、発表内容とスライドを元に、深層学習の基礎や課題、そして深層学習モデルの進化について解説していきます。

深層学習の基礎:CNNとDNNのおさらい

まずは、深層学習の基礎となるCNNとDNNについておさらいしましょう。

CNN(畳み込みニューラルネットワーク)とは?

CNNは、画像認識などの分野で広く用いられている深層学習モデルです。

特徴としては、畳み込み層とプーリング層を交互に重ねることで、画像の特徴を段階的に抽出していく点が挙げられます。

DNN(深層ニューラルネットワーク)とは?

DNNは、多層のニューラルネットワークで、様々なタスクに適用可能な汎用性の高いモデルです。

入力層から出力層まで、複数の層で構成され、各層で特徴抽出や分類処理が行われます。

深層学習の課題:勾配消失問題

CNNやDNNをより深くすることで、より複雑なタスクに対応できるようになり、精度の向上も期待できます。

しかし、層を深くしていくと、勾配消失問題という課題に直面することがあります。

勾配消失問題とは?

勾配消失問題とは、深層学習において、ネットワークの層が深くなるにつれて、誤差逆伝播法で計算される勾配が小さくなり、学習がうまく進まなくなる現象のことです。

勾配消失問題が起こる原因

なぜ勾配が消失してしまうのでしょうか?

それは、誤差逆伝播法の仕組みと深く関係しています。

誤差逆伝播法では、出力層から入力層に向かって、誤差を元に重みを更新していくのですが、層が深くなると、微分値が連鎖的に掛け合わされるため、値が小さくなってしまい、結果的に勾配が消失してしまいます。

勾配消失問題への対策

では、勾配消失問題をどのように解決すればいいのでしょうか?

深層学習モデルの進化の歴史の中で、この問題を解決するための様々な工夫が凝らされてきました。

深層学習モデルの進化:ResNetとInceptionモジュール

ResNet:スキップ接続で層を深く

ResNetは、2015年に登場した深層学習モデルで、スキップ接続という革新的な仕組みを取り入れています。

スキップ接続とは、ある層の出力を、その後の層に直接渡すことで、勾配が消失するのを防ぐ仕組みです。

これにより、理論上は無限に層を重ねることが可能になり、より複雑なタスクにも対応できるようになりました。

Inceptionモジュール:多様なフィルターで特徴を抽出

Inceptionモジュールは、GoogLeNetで提案された、CNNのアーキテクチャです。

Inceptionモジュールでは、異なるサイズのフィルターを複数用いて畳み込みを行い、その結果を結合することで、より多様な特徴を抽出することを可能にしました。

まとめ

今回のEarl Klutzさんの発表では、深層学習の基礎から、深層化における課題、そしてその課題を解決するための革新的なモデルについて学ぶことができました。

深層学習は、画像認識や自然言語処理など、様々な分野で活用されていますが、その発展には、勾配消失問題などの課題を克服する必要がありました。

ResNetやInceptionモジュールといった革新的なモデルは、深層学習の進化に大きく貢献し、AI技術の更なる発展を牽引しています。

深層学習は、まだまだ発展途上の分野であり、今後も新たな課題や解決策が生まれてくるでしょう。

今回の発表をきっかけに、深層学習についてさらに興味を持った方は、ぜひ今回のスライドを参考に、より深く学習を進めてみてください。

ML集会の他の発表もチェック!

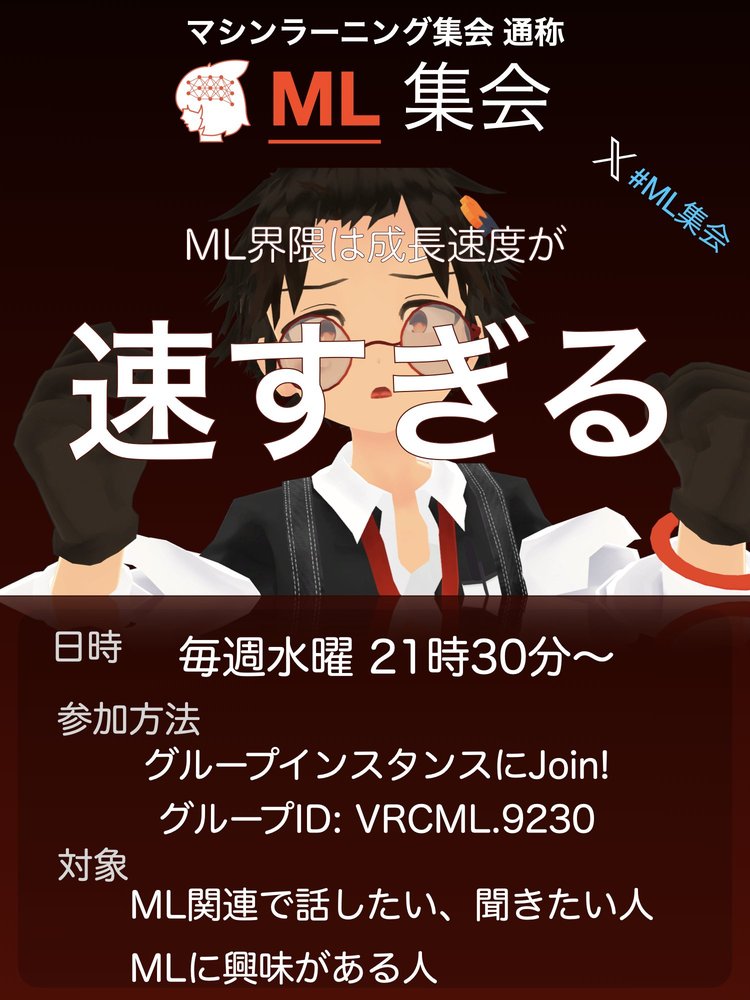

ML集会の開催情報・参加方法

ML集会

開催日: 2023年06月07日

開催時間: 21:30 - 22:30

開催曜日: 水曜日開催周期: 毎週

機械学習(AI)関連でお話しつつ、LTなどをする情報共有会です! 最近のML界隈は成長が速すぎるからみんなで追おう!という思いから生まれました。 現在は自律動作するAIアバターがいたりして... あなたの目の前にいる存在は人ではないかもしれません。 Discordもあるのでそちらもぜひ。